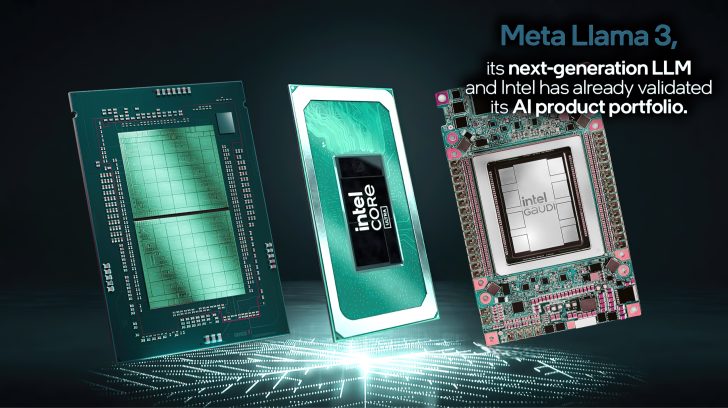

Intel объявила о проверке и оптимизации своих линеек продуктов Xeon, Core Ultra, Arc и Gaudi для новейших рабочих нагрузок Meta Llama 3 GenAI.

Intel проверяет и тестирует рабочие нагрузки Llama 3 GenAI компании Meta в своих процессорах Xeon, процессорах Core Ultra, графических процессорах Arc и ускорителях Gaudi

Пресс-релиз: Сегодня компания Meta запустила Meta Llama 3 , свою модель большого языка (LLM) следующего поколения. В день запуска компания Intel утвердила свой портфель продуктов искусственного интеллекта для первых моделей Llama 3 8B и 70B с ускорителями Gaudi, процессорами Xeon, процессорами Core Ultra и графическими процессорами Arc.

Почему это важно. В рамках своей миссии по распространению искусственного интеллекта повсюду компания Intel инвестирует в программное обеспечение и экосистему искусственного интеллекта, чтобы гарантировать, что ее продукты готовы к новейшим инновациям в динамичной сфере искусственного интеллекта. В центрах обработки данных процессоры Gaudi и Xeon с ускорением Advanced Matrix Extension (AMX) предоставляют клиентам возможность удовлетворить динамические и разнообразные требования.

Процессоры Intel Core Ultra и графические продукты Arc обеспечивают как средство локальной разработки, так и развертывание на миллионах устройств с поддержкой комплексных программных платформ и инструментов, включая PyTorch и Intel Extension для PyTorch, используемых для локальных исследований и разработок, а также набор инструментов OpenVINO для разработки моделей и вывода. .

О процессоре Llama 3, работающем на платформе Intel. При первоначальном тестировании и результатах производительности моделей Llama 3 8B и 70B компания Intel использовала программное обеспечение с открытым исходным кодом, включая PyTorch, DeepSpeed, библиотеку Optimum Habana и расширение Intel для PyTorch, обеспечивающее новейшую оптимизацию программного обеспечения.

- Ускорители Intel Gaudi 2 оптимизировали производительность моделей Llama 2 — параметры 7B, 13B и 70B — и теперь имеют первоначальные измерения производительности для новой модели Llama 3. Благодаря зрелости программного обеспечения Гауди Intel легко запустила новую модель Llama 3 и получила результаты для вывода и точной настройки. Llama 3 также поддерживается недавно анонсированным ускорителем Gaudi 3.

- Процессоры Intel Xeon справляются со сложными сквозными рабочими нагрузками искусственного интеллекта, а Intel инвестирует в оптимизацию результатов LLM для уменьшения задержек. Процессоры Xeon 6 с ядрами Performance (под кодовым названием Granite Rapids) демонстрируют двукратное улучшение задержки вывода Llama 3 8B по сравнению с процессорами Xeon 4-го поколения и возможность запуска более крупных языковых моделей, таких как Llama 3 70B, со скоростью менее 100 мс на каждый сгенерированный токен.

- Intel Core Ultra и Arc Graphics обеспечивают впечатляющую производительность для Llama 3. В первом раунде тестирования процессоры Core Ultra уже обеспечивают скорость чтения, превышающую обычную человеческую скорость. Кроме того, графический процессор Arc A770 оснащен искусственным интеллектом X e Matrix eXtensions (XMX) и 16 ГБ выделенной памяти, что обеспечивает исключительную производительность для рабочих нагрузок LLM.

Масштабируемые процессоры Xeon

Intel постоянно оптимизирует вывод LLM для платформ Xeon. Например, по сравнению с версией Llama 2, улучшения программного обеспечения для запуска PyTorch и расширения Intel для PyTorch позволили сократить задержку в 5 раз. Оптимизация использует постраничное внимание и тензорную параллель, чтобы максимизировать использование доступных вычислений и пропускную способность памяти. На рис. 1 показана производительность вывода Meta Llama 3 8B на экземпляре AWS m7i.metal-48x, который основан на масштабируемом процессоре Xeon 4-го поколения.

Мы протестировали Meta Llama 3 на процессоре Xeon 6 с ядрами Performance (ранее под кодовым названием Granite Rapids), чтобы поделиться предварительным обзором производительности. Эти предварительные цифры демонстрируют, что Xeon 6 обеспечивает двукратное улучшение задержки вывода Llama 3 8B по сравнению с широко доступными процессорами Xeon 4-го поколения, а также возможность запуска более крупных языковых моделей, таких как Llama 3 70B, менее 100 мс на каждый сгенерированный токен на одном двухъядерном процессоре. сокет-сервер.

| Модель | ТП | Точность | Входная длина | Выходная длина | Пропускная способность | Задержка* | Партия |

| Мета-Лама-3-8B-Инструктировать | 1 | fp8 | 2 тыс. | 4к | 1549,27токен/сек | 7.747РС | 12 |

| Мета-Лама-3-8B-Инструктировать | 1 | бф16 | 1 тыс. | 3 тыс. | 469,11токен/сек | 8.527РС | 4 |

| Мета-Лама-3-70Б-Инструктировать | 8 | fp8 | 2 тыс. | 4к | 4927,31токен/сек | 56,23РС | 277 |

| Мета-Лама-3-70Б-Инструктировать | 8 | бф16 | 2 тыс. | 2 тыс. | 3574,81токен/сек | 60,425РС | 216 |

Клиентские платформы

На начальном этапе оценки процессор Intel Core Ultra уже обеспечивает скорость чтения, превышающую обычную для человека. Эти результаты обусловлены встроенным графическим процессором Arc с 8 ядрами Xe, включая ускорение искусственного интеллекта DP4a и пропускную способность системной памяти до 120 ГБ/с. Мы рады инвестировать в дальнейшую оптимизацию производительности и энергоэффективности Llama 3, особенно по мере перехода на наши процессоры следующего поколения.

Благодаря поддержке процессоров Core Ultra и графических продуктов Arc в день запуска сотрудничество между Intel и Meta обеспечивает как локальную среду разработки, так и развертывание на миллионах устройств. Клиентское оборудование Intel ускоряется с помощью комплексных программных платформ и инструментов, включая PyTorch и Intel Extension для PyTorch, используемых для локальных исследований и разработок, а также OpenVINO Toolkit для развертывания моделей и получения логических выводов.

Что дальше: В ближайшие месяцы Meta планирует представить новые возможности, дополнительные размеры моделей и повышенную производительность. Intel продолжит оптимизировать производительность своих продуктов искусственного интеллекта для поддержки нового LLM.