Графический процессор B200 с двумя кристаллами имеет в 4 раза большую производительность обучения искусственного интеллекта и в 30 раз большую производительность вывода, чем его предшественник.

Nvidia в настоящее время занимает лидирующие позиции в мире искусственного интеллекта, предлагая графические процессоры для центров обработки данных, которые нужны всем. Ее супер чипы Hopper H100 и GH200 Grace Hopper пользуются серьезным спросом и используются во многих самых мощных суперкомпьютерах в мире. Что ж, оставайтесь на своих местах, потому что Nvidia только что представила преемника Hopper. Генеральный директор Дженсен Хуанг сегодня сбросил бомбу Blackwell B200, центр обработки данных следующего поколения и графический процессор искусственного интеллекта, который обеспечит огромный скачок в вычислительной мощности между поколениями.

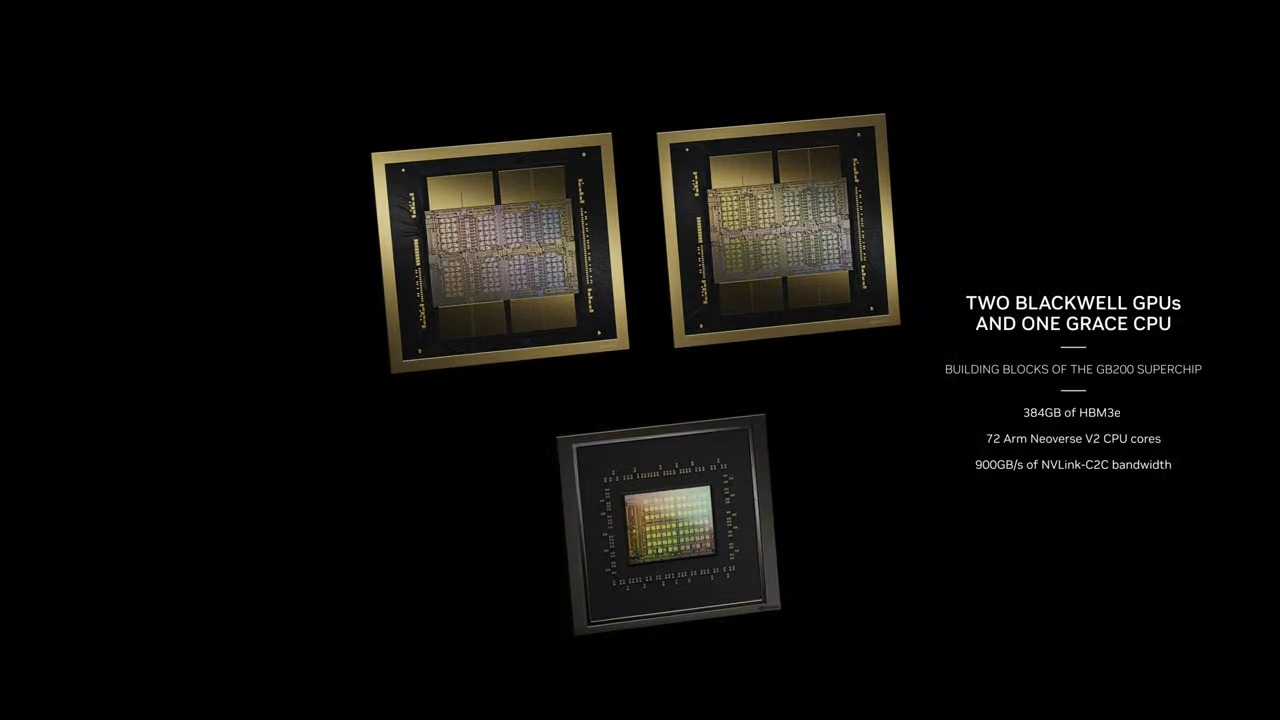

Архитектура Blackwell и графический процессор B200 пришли на смену H100/H200. Также будет суперчип Grace Blackwell GB200 , который, как можно догадаться по названию, сохранит архитектуру процессора Grace, но будет сочетаться с обновленным графическим процессором Blackwell. Мы ожидаем, что Nvidia в конечном итоге также выпустит графические процессоры Blackwell потребительского класса, но они могут появиться не раньше 2025 года и будут сильно отличаться от чипов для центров обработки данных.

ГРАФИЧЕСКИЙ ПРОЦЕССОР NVIDIA BLACKWELL

На высоком уровне графический процессор B200 более чем вдвое увеличивает количество транзисторов по сравнению с существующим H100. Есть некоторые предостережения, к которым мы вскоре вернемся, но B200 содержит 208 миллиардов транзисторов (по сравнению с 80 миллиардами в H100/H200). Он также обеспечивает 20 петафлопс производительности ИИ от одного графического процессора — у одного H100 было максимум 4 петафлопс вычислений ИИ. И последнее, но не менее важное: он будет оснащен 192 ГБ памяти HBM3e с пропускной способностью 8 ТБ/с.

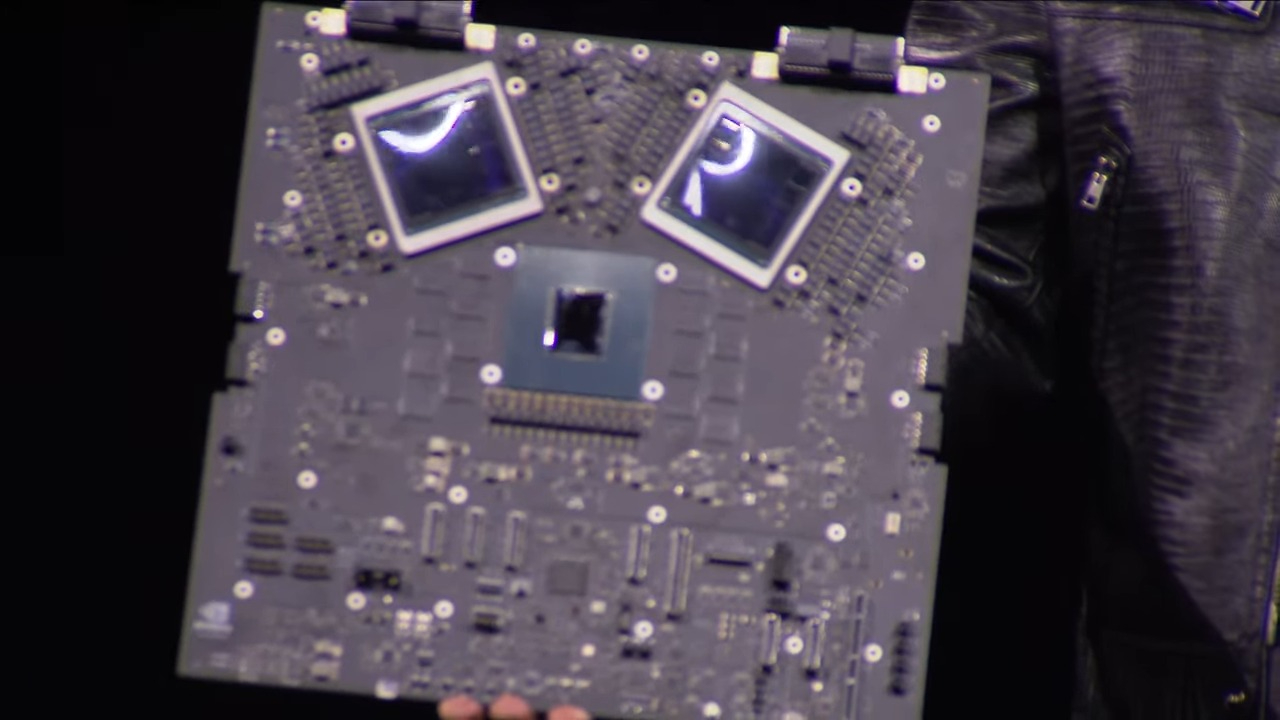

Теперь давайте поговорим о некоторых предостережениях. Прежде всего, как указывают слухи, Blackwell B200 — это не один графический процессор в традиционном понимании. Вместо этого он состоит из двух тесно связанных кристаллов , хотя, по словам Nvidia, они функционируют как один унифицированный графический процессор CUDA. Два чипа связаны через соединение NV-HBI (Nvidia High Bandwidth Interface) со скоростью 10 ТБ/с, чтобы гарантировать их правильную работу как один полностью когерентный чип.

Причина такой конфигурации с двумя кристаллами проста: Blackwell B200 будет использовать технологический узел TSMC 4NP, усовершенствованную версию процесса 4N, используемого в существующих графических процессорах с архитектурой Hopper H100 и Ada Lovelace . У нас нет подробной информации о TSMC 4NP, но он, вероятно, не предлагает значительного улучшения плотности функций, а это означает, что если вам нужен более мощный чип, вам нужен способ стать больше. Это сложно, поскольку H100, по сути, уже представлял собой чип полного размера сетки — размер кристалла у него составлял 814 мм2, тогда как теоретический максимум составляет 858 мм2.

B200 будет использовать два чипа полного размера прицельной сетки, хотя Nvidia пока не предоставила точный размер кристалла. Каждый кристалл имеет четыре стека HMB3e по 24 ГБ каждый с пропускной способностью 1 ТБ/с каждый на 1024-битном интерфейсе. Обратите внимание, что у H100 было шесть стеков HBM3 по 16 ГБ каждый (изначально — H200 увеличил это число до шести на 24 ГБ), что означает, что приличная часть кристалла H100 была отведена под шесть контроллеров памяти. Уменьшив количество интерфейсов HBM на один чип и объединив два чипа вместе, Nvidia может выделить пропорционально меньше площади кристалла для интерфейсов памяти.

Второе предостережение, которое нам нужно обсудить, касается максимальной теоретической производительности в 20 петафлопс. Blackwell B200 достигает этого показателя благодаря новому формату чисел FP4, обеспечивающему вдвое большую пропускную способность по сравнению с форматом FP8 Hopper H100. Итак, если бы мы сравнивали яблоки с яблоками и придерживались FP8, B200 «только» предлагает в 2,5 раза больше теоретических вычислений FP8, чем H100 (с разреженностью), и большая часть этого связана с наличием двух чипов.

Это интересный момент, который снова восходит к отсутствию значительного улучшения плотности за счет узла процесса 4NP. B200 теоретически обеспечивает в 1,25 раза больше вычислений на чип с большинством числовых форматов, которые поддерживаются как H100, так и B200. Удаление двух интерфейсов HBM3 и создание чипа немного большего размера может означать, что плотность вычислений даже не будет значительно выше на уровне чипа — хотя, конечно, интерфейс NV-HBI между двумя чипами также занимает некоторую площадь кристалла.

Nvidia также предоставила необработанные вычисления для других числовых форматов с помощью B200, при этом применяются обычные коэффициенты масштабирования. Таким образом, пропускная способность FP8 составляет половину пропускной способности FP4 при 10 петафлопс, пропускная способность FP16/BF16 вдвое превышает показатель FP8 при 5 петафлопс, а поддержка TF32 вдвое ниже пропускной способности FP16 при 2,5 петафлопс — все они с разреженностью, поэтому половина этих показателей для плотные операции. Опять же, во всех случаях это в 2,5 раза больше, чем у одного H100.

А как насчет пропускной способности FP64? H100 имел производительность 60 терафлопс плотных вычислений FP64 на графический процессор. Если бы B200 имел такое же масштабирование, как и другие форматы, каждый двух кристальный графический процессор имел бы производительность 150 терафлопс. Однако похоже, что Nvidia немного снижает производительность FP64: 45 терафлопс FP64 на графический процессор. Но это также требует некоторых пояснений, поскольку одним из ключевых строительных блоков будет супер чип GB200. Он имеет два графических процессора B200 и может выполнять 90 терафлопс плотного FP64, а также действуют другие факторы, которые могут улучшить необработанную пропускную способность при классическом моделировании по сравнению с H100.

Что касается использования FP4, у Nvidia есть новый Transformer Engine второго поколения, который поможет автоматически конвертировать модели в соответствующий формат для достижения максимальной производительности. Помимо поддержки FP4, Blackwell также будет поддерживать новый формат FP6 — промежуточное решение для ситуаций, когда FP4 не хватает необходимой точности, но и FP8 не нужен. Какой бы ни была полученная точность, Nvidia классифицирует такие варианты использования как модели «Смесь экспертов»

Нам также необходимо прояснить некоторые вещи, поскольку доступно несколько различных вариантов Блэквелла. Первоначально Nvidia предоставляет спецификации полных серверных узлов, и существует три основных варианта.

Самым большим и быстрым будет суперчип GB200, о котором мы поговорим подробнее ниже, но, как уже отмечалось, он оснащен двумя графическими процессорами B200. Полные суперчипы имеют настраиваемый TDP до 2700 Вт. Это для двух графических процессоров и четырех графических процессоров, а также одного процессора Grace. Цифры, которые мы только что привели выше — до 20 петафлопс FP4 для одного B200 — относятся к половине суперчипа GB200.

Следующим шагом является HGX B200, который основан на использовании восьми графических процессоров B200 с процессором x86 (вероятно, двух процессоров) в одном серверном узле. Их можно настроить до 1000 Вт на графический процессор B200, а графические процессоры обеспечивают пропускную способность FP4 до 18 петафлопс, что на 10% медленнее, чем графические процессоры в GB200.

Наконец, будет также HGX B100. Это та же основная идея, что и у HGX B200, с процессором x86 и восемью графическими процессорами B100, за исключением того, что он разработан для полной совместимости с существующей инфраструктурой HGX H100 и позволяет наиболее быстро развертывать графические процессоры Blackwell. Таким образом, TDP на каждый графический процессор ограничен 700 Вт, как и у H100, а пропускная способность падает до 14 петафлопс FP4.

Важно отметить, что на всех трех этих серверах HBM3e имеет одинаковую пропускную способность 8 ТБ/с на каждый графический процессор. поэтому различаются только мощность, а также частота ядер графического процессора и, возможно, количество ядер. Nvidia пока не раскрыла никаких подробностей о том, сколько ядер CUDA или потоковых мультипроцессоров будет доступно в любом из графических процессоров Blackwell.

НВИДИА НВЛИНК 7.2Т

Речь идет не только о вычислительных ресурсах и пропускной способности памяти. Одним из серьезных ограничивающих факторов в рабочих нагрузках искусственного интеллекта и высокопроизводительных вычислений является пропускная способность межузлового соединения для связи между различными узлами. По мере увеличения количества графических процессоров связь становится серьезным узким местом и может составлять до 60% используемых ресурсов и времени. С B200 Nvidia представляет NVLink пятого поколения и NVLink Switch 7.2T.

Новый чип NVLink имеет двунаправленную пропускную способность 1,8 ТБ/с и поддерживает домен NVLink с 576 графическими процессорами. Это чип на 50 миллиардов транзисторов, изготовленный на том же узле TSMC 4NP. Чип также поддерживает 3,6 терафлопс внутрисетевых вычислений Sharp v4, что может помочь в эффективной обработке более крупных моделей.

Предыдущее поколение поддерживало пропускную способность HDR InfiniBand до 100 ГБ/с, так что это огромный скачок в пропускной способности. Новый NVSwitch обеспечивает ускорение в 18 раз по сравнению с многоузловым соединением H100. Это должно позволить значительно улучшить масштабирование для сетей искусственного интеллекта с более крупными триллионами параметров.

В связи с этим каждый графический процессор Blackwell оснащен 18 соединениями NVLink пятого поколения. Это в восемнадцать раз больше ссылок, чем у H100. Каждое соединение обеспечивает двунаправленную пропускную способность 50 ГБ/с или 100 ГБ/с на канал.

НВИДИА Б200 НВЛ72

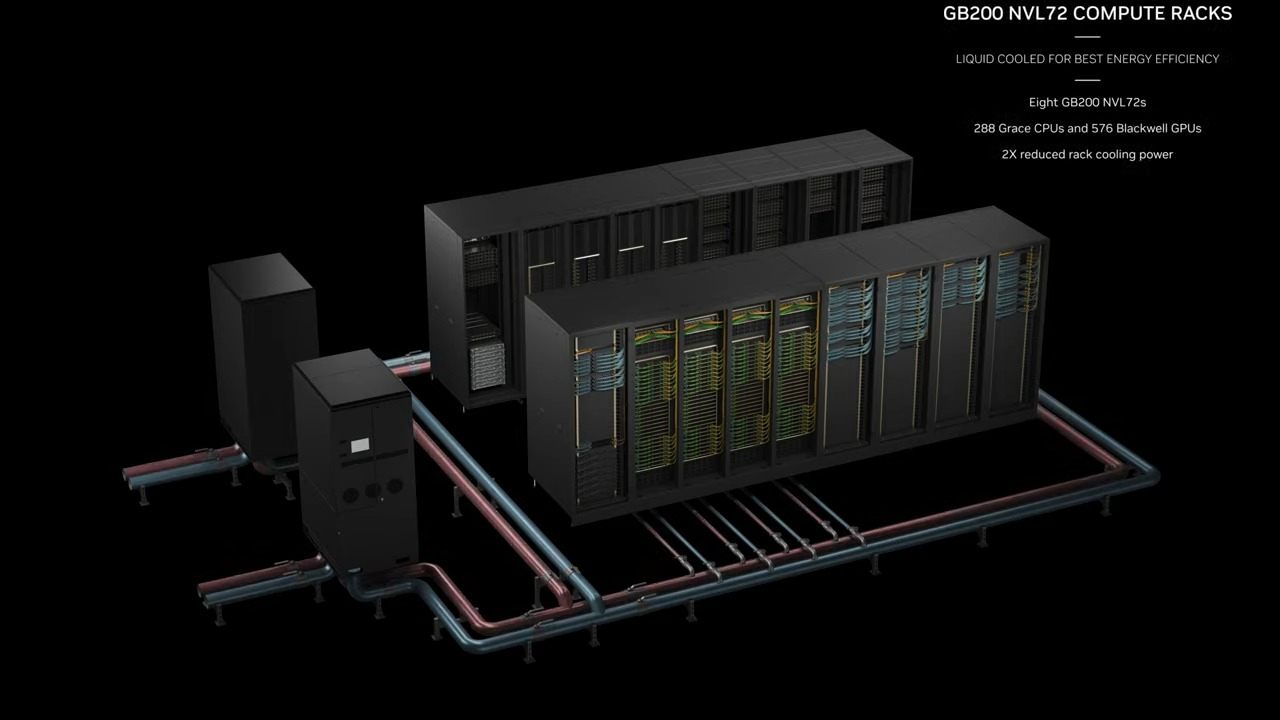

Возьмите вышеперечисленное и соедините их вместе, и вы получите новые системы Nvidia GB200 NVL72. По сути, это полноценное решение с 18 серверами высотой 1U, каждый из которых оснащен двумя супер чипами GB200. Однако здесь есть некоторые различия по сравнению с предыдущим поколением с точки зрения того, что представляет собой супер чип GB200. Изображение и характеристики показывают, что два графических процессора B200 соответствуют одному процессору Grace, тогда как GH100 использовал решение меньшего размера, в котором один процессор Grace размещался рядом с одним графическим процессором H100.

Конечным результатом является то, что вычислительный блок супер чипа GB200 будет иметь два процессора Grace и четыре графических процессора B200 с производительностью 80 петафлопс для вывода искусственного интеллекта FP4 и 40 петафлопс для обучения искусственного интеллекта FP8. Это серверы высотой 1U с жидкостным охлаждением, которые занимают большую часть обычного пространства в стойке (42 единицы).

Помимо вычислительных лотков для супер чипов GB200, GB200 NVL72 также будет оснащен лотками для переключателей NVLink. Это также лотки высотой 1U с жидкостным охлаждением, с двумя коммутаторами NVLink на каждый лоток и девятью такими лотками на стойку. Каждый лоток обеспечивает общую пропускную способность 14,4 ТБ/с, а также вышеупомянутые вычисления Sharp v4.

В общей сложности GB200 NVL72 оснащен 36 процессорами Grace и 72 графическими процессорами Blackwell с вычислительной мощностью 720 петафлопс FP8 и 1440 петафлопс вычислений FP4. Пропускная способность нескольких узлов составляет 130 ТБ/с, и Nvidia заявляет, что NVL72 может обрабатывать до 27 триллионов параметров моделей для AI LLM.

0 Комментариев